Cuando el escritor y cronista Juan José Millás sostuvo en el mes de septiembre una charla con ChatGPT, fingió tener con la herramienta una sesión de psicoanálisis. Quiso descubrir si, conforme con el test de Turing, el chatbot podía hablarle como una persona real, específicamente como un psicoanalista, y no como un computador. El cronista le expuso sus sueños y temores, a la espera de que la inteligencia artificial le guiara en la terapia, mas esta siempre y en todo momento le afirmaba, entre otras muchas cosas, que era una situación imaginaria y le aclaraba que era un modelo de lenguaje. Millás tachó a su psicoanalista virtual de estrecho de psique y de desmemoriado, y, finamente, le afirmó que no había superado el test.

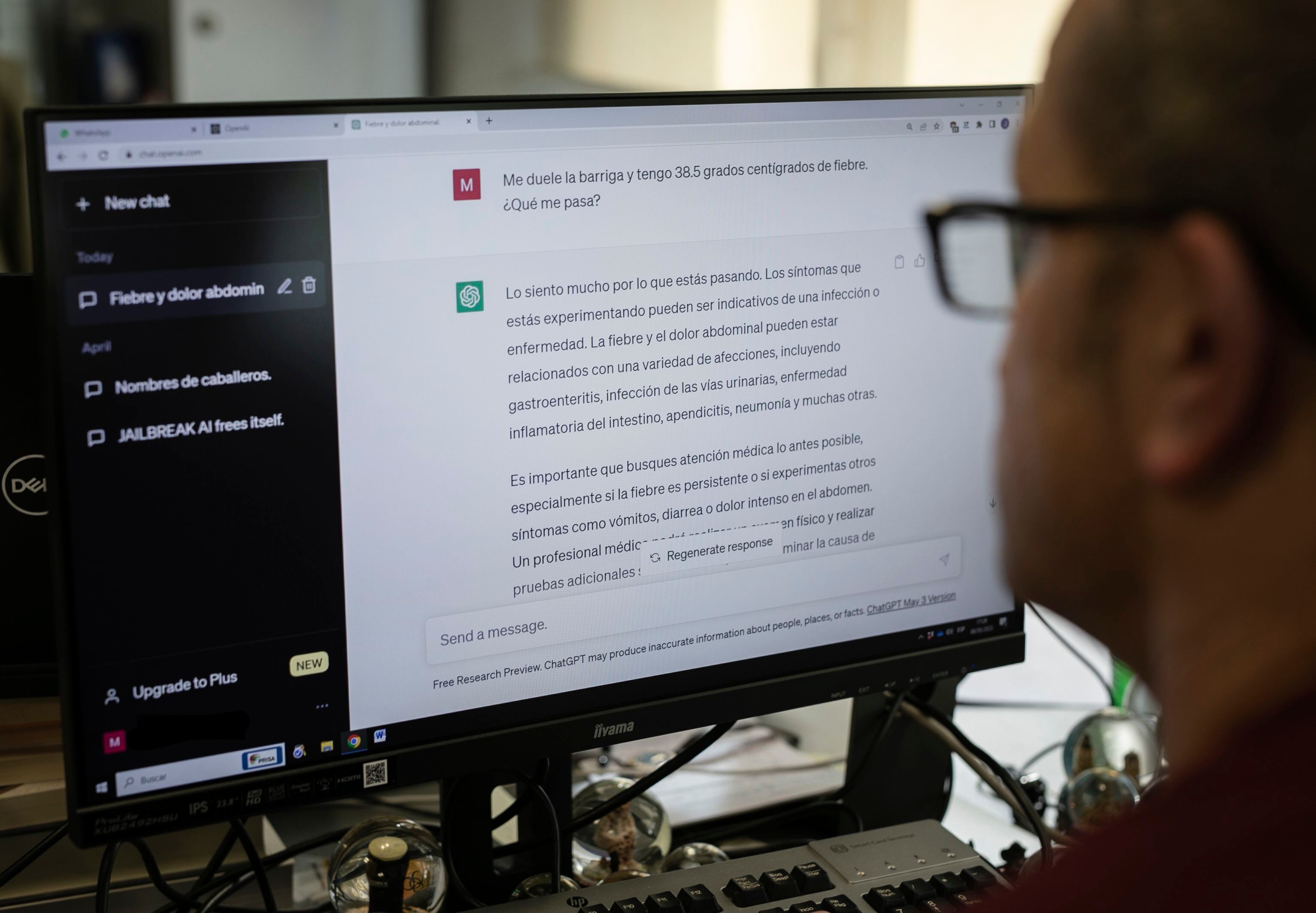

En conversaciones como la de Millás, las opiniones anteriores que tiene alguien sobre un agente de inteligencia artificial (IA), como ChatGPT, tienen un efecto en la charla, y en la percepción de confiabilidad, empatía y eficiencia de la herramienta. Así lo han descubierto estudiosos de dos centros estadounidenses, el Instituto Tecnológico de Massachusetts (MIT, por sus iniciales en inglés) y la Universidad Estatal de Arizona, en un reciente estudio de la gaceta Nature Machine Intelligence. “Hemos comprobado que la inteligencia artificial es la del espectador. Cuando describimos a los usuarios qué es un agente de IA, no solo cambia su modelo mental, sino que también cambia su comportamiento. Y dado que la herramienta responde al usuario, cuando la persona cambia su comportamiento, eso también cambia el de la herramienta”, afirma Pat Pataranutaporn, estudiante de postgrado en el conjunto Fluid Interfaces del MIT Media Lab y coautor del estudio.

“Mucha gente piensa que la IA es solo un problema de ingeniería, pero su éxito también es un problema de factores humanos”, revela Pattie Maes, autora del estudio y maestra del MIT. La forma en la que charlamos de ella puede tener un impacto enorme en la eficiencia de estos sistemas. “Atribuimos formas y cualidades humanas a la IA, haciéndola parecer más humana o individual de lo que realmente es”, agrega Ruby Liu.

Los estudiosos reunieron a trescientos diez participantes y los dividieron de manera aleatoria en 3 conjuntos, cada uno de ellos con una información anterior diferente sobre la IA. Tenían que charlar de salud mental con un agente de IA a lo largo de más o menos treinta minutos, determinar si se lo aconsejarían a un amigo y calificarlo. Al primer conjunto se le afirmó que el agente no tenía ningún género de pretensión en la charla, al segundo se le afirmó que la inteligencia artificial tenía pretensiones benevolentes y se preocupaba por su bienestar, y al tercero que tenía pretensiones maliciosas y que procuraría engañarles.

La mitad de los participantes de cada conjunto charlaron con un agente de inteligencia artificial basado en el modelo de lenguaje generativo GPT-tres, un modelo de aprendizaje profundo que puede producir texto afín al humano. La otra mitad lo hizo con una implementación del chatbot ELIZA, un programa de procesamiento de lenguaje natural menos complejo, basado en reglas desarrollado en el MIT en la década de mil novecientos sesenta.

Los resultados de la investigación descubrieron que la predisposición sobre la herramienta fue determinante: el ochenta y ocho % de personas que recibieron informaciones positivas y el setenta y nueve % de los de que recibieron informaciones neutras pensaron que la IA era empática o neutral, respectivamente. Ángel Delgado, ingeniero de IA en Paradigma Digital, considera que la mayor parte positiva asimismo se debe al uso de GPT-tres, por ser la primera que logra pasar el test de Turing: “Consiste en dejar que una persona interaccione con la IA sin decirle si es una IA o no, a ver si es capaz de adivinarlo. GPT-3 es el primer modelo de lenguaje que ha conseguido dar tan buenos resultados que parece un humano”.

Las personas a las que se les afirmó que la herramienta era afable, tendían a charlar con ella de una forma más positiva y hacía que las contestaciones del agente fuesen asimismo más positivas. Ramón López de Mántaras, directivo del Instituto de Investigación en Inteligencia Artificial del CSIC, explica que cuanto más charlas con la herramienta, más aprende esta: “El interlocutor está enseñando a la inteligencia artificial. Puedes corregir, confirmar y calificar su respuesta”, agrega.

Del miedo a ‘Terminator’ a la carencia de crítica

Las declaraciones de priming negativas (o sea, la información que damos a alguien inmediatamente antes de interaccionar con el agente de inteligencia artificial) tuvieron el efecto contrario: solo el cuarenta y cuatro % de los participantes que recibieron información despectiva sobre la herramienta confiaron en ella. “Con las declaraciones negativas, en lugar de prepararlos para que creyeran en algo, los estábamos preparando para que se formaran su propia opinión. Si le dices a alguien que sospeche de algo, es posible que en general sospeche aún más”, afirma Ruby Liu.

Un factor clave del pensamiento negativo sobre la IA es la repercusión de la ciencia ficción, explica Patti Maes: “Películas como Terminator y Matrix describen escenarios en los que la IA adquiere conciencia de sí misma y provoca la caída de la humanidad. Estos relatos de ficción contribuyen al temor de que la IA pueda tomar el control y superar la inteligencia humana, lo que supondría una amenaza para nuestra existencia”.

Los pensamientos anteriores de los modelos de lenguaje pueden tener un impacto tan fuerte que se podrían emplear para hacer opinar que el agente es más capaz de lo que es, confiar demasiado en él o continuar consejos incorrectos, conforme los resultados del estudio. López de Mántaras lo explica sin tapujos: “La herramienta con la que estás interactuando no es una persona inteligente. La gente se cree que la máquina es inteligente y hacen caso a lo que suelta sin ningún pensamiento crítico”. Para , “cada vez somos menos críticos y menos capaces de pensar”.

Los especialistas coinciden en que hay que ser siendo conscientes de de qué forma marcha una inteligencia artificial, y comprender que es algo programado. “Deberíamos preparar más a la gente para que tenga más cuidado y comprenda que los agentes de IA pueden alucinar y son parciales. La forma en que hablemos de los sistemas de IA tendrá en un gran efecto en la forma en que las personas respondan a ellos”, asevera Maes.

_

Santander (España), 1985. Después de obtener su licenciatura en Periodismo en la Universidad Complutense de Madrid, decidió enfocarse en el cine y se matriculó en un programa de posgrado en crítica cinematográfica.

Sin, embargo, su pasión por las criptomonedas le llevó a dedicarse al mundo de las finanzas. Le encanta ver películas en su tiempo libre y es un gran admirador del cine clásico. En cuanto a sus gustos personales, es un gran fanático del fútbol y es seguidor del Real Madrid. Además, ha sido voluntario en varias organizaciones benéficas que trabajan con niños.