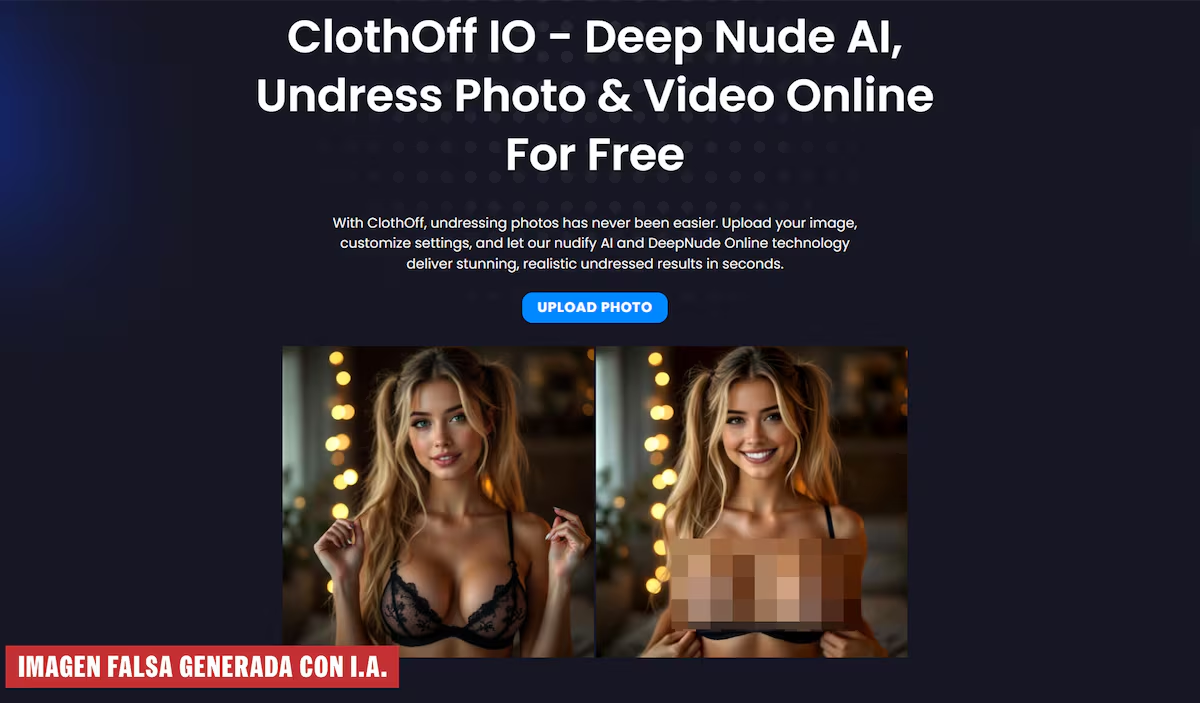

En octubre de 2023, un inquietante incidente ocurrido en un instituto de Nueva Jersey encendió el debate sobre el uso de la inteligencia artificial en la difamación y el acoso. Un grupo de jóvenes tomó una foto de una compañera, de solo 14 años, desde su Instagram, y la procesaron en ClothOff, una app que genera imágenes desnudas mediante IA. Posteriormente, compartieron la imagen en Snapchat, generando un efecto devastador en la vida de la víctima, quien ha expresado un temor constante de que su imagen falsa resurja en la web. La joven ha decidido llevar a ClothOff a los tribunales, buscando justicia frente a una empresa que, según su denuncia, se aprovecha de la explotación sexual y el abuso facilitados por la tecnología.

La demanda contra ClothOff

Brina Harden, miembro del Centro de Libertad de Medios de la Universidad de Yale, lamenta que «esta empresa parece funcionar únicamente para capitalizar el abuso sexual». La denuncia destaca el aumento desenfrenado del uso de estos servicios, que no solo crecen en popularidad, sino que también añaden nuevas funciones, incluyendo videos y diferentes posturas de las víctimas. Las cifras son alarmantes: ClothOff reportó 27 millones de usuarios en sus primeros meses de 2024, generando cerca de 200,000 imágenes diariamente. Su modelo económico se basa en suscripciones y la compra de créditos.

Un referente en el problema

La situación en España no es menos preocupante. Un caso en Almendralejo, que ocurrió apenas un mes antes del incidente en Nueva Jersey, puso de manifiesto la falta de conocimiento alrededor de las deepfakes. Miriam Al Adib, madre de una de las afectadas, compartió que «al principio, incluso la policía dudó sobre cómo proceder». Estos jóvenes fueron acusados de pornografía infantil e infracción de la integridad moral. Desde mayo, Estados Unidos cuenta con una legislación que prohíbe la difusión de imágenes íntimas sin consentimiento, incluyendo aquellas generadas por IA.

El objetivo de la demanda en Estados Unidos es cerrar de manera definitiva ClothOff. Su éxito podría abrir un camino para que otras personas presenten también acciones legales contra aplicaciones similares. Sin embargo, la tarea se complica por la cantidad de plataformas que ofrecen servicios similares, muchas de ellas vinculadas a ClothOff.

Un fenómeno global

Los casos de abuso mediante IA no se limitan a Estados Unidos. En España se han registrado varios incidentes, como el de un joven en Valencia que fue arrestado por desnudar fotos de compañeras de clase sin su consentimiento. Mientras tanto, en Japón, un hombre fue detenido por crear más de 20,000 imágenes de 262 mujeres, vendiendo acceso a este contenido.

Incluso en medio de este caos, CloffOff continua operando, ofreciendo sofisticadas herramientas como una API que permite automatizar la creación de contenido pornográfico. La facilidad de acceso a este tipo de tecnologías hace que se dispare la preocupación sobre la pornografía infantil y los daños asociados.

La lucha contra la explotación

Este problema ha llevado a algunos estados, como California e Italia, a intentar bloquear el acceso a estas plataformas. Sin embargo, como señala Brina Harden, “ClothOff fue diseñado para ser anónimo y de fácil acceso”. Con solo tres clics, los usuarios pueden generar imágenes desnudas sin verificar la edad.

Mientras que las búsquedas relacionadas con ClothOff han aumentado en las tendencias de Google, la preocupación por el potencial de estas aplicaciones sigue latente. Con múltiples ejemplos de abuso en el horizonte, el compromiso para luchar contra estos sistemas de explotación es más urgente que nunca. La lucha está lejos de terminar, y cada pequeña victoria parece estar respaldada por el esfuerzo colectivo de quienes se niegan a mirar hacia otro lado.